近期,中國科學(xué)院合肥物質(zhì)院智能所謝成軍與張潔團(tuán)隊將多模態(tài)融合方法應(yīng)用于遙感圖像全色銳化領(lǐng)域,相關(guān)研究成果以“Exploring Text-Guided Information Fusion Through Chain-of-Reasoning for Pansharpening”為題發(fā)表在地球科學(xué)和遙感領(lǐng)域的中國科學(xué)院一區(qū)Top期刊IEEE Transactions on Geoscience and Remote Sensing?(IEEE TGRS)上。

遙感圖像全色銳化技術(shù)旨在融合低分辨率的多光譜(LRMS)圖像與高分辨率的全色(PAN)圖像,以生成兼具高空間分辨率和豐富光譜信息的遙感影像。盡管由文本引導(dǎo)的多模態(tài)學(xué)習(xí)方法在自然圖像領(lǐng)域已經(jīng)取得了顯著進(jìn)展,但由于全色銳化領(lǐng)域多模態(tài)數(shù)據(jù)集的缺乏,以及遙感場景的復(fù)雜性等問題,為語義信息的準(zhǔn)確提取帶來了巨大挑戰(zhàn)。

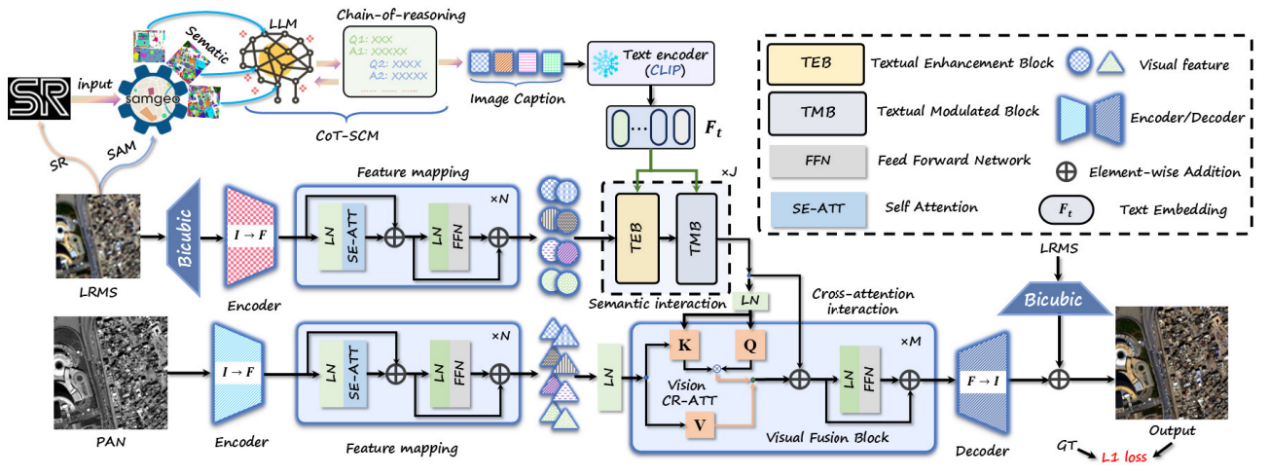

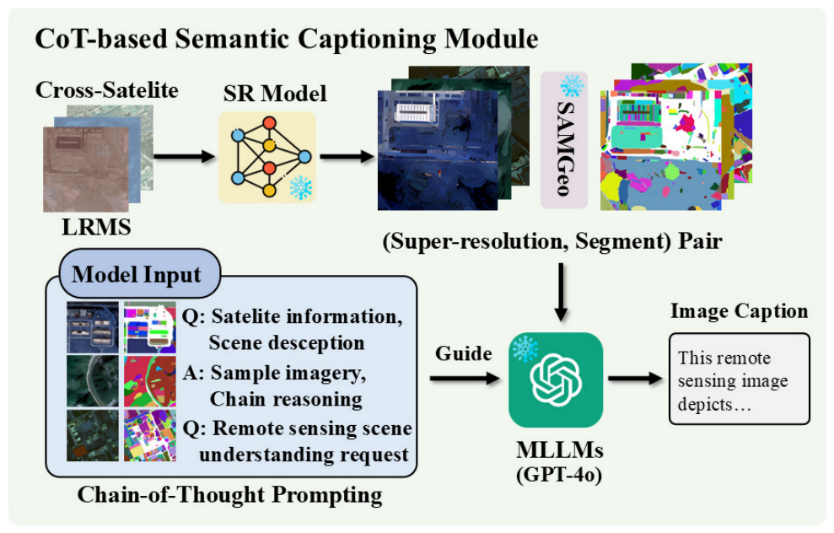

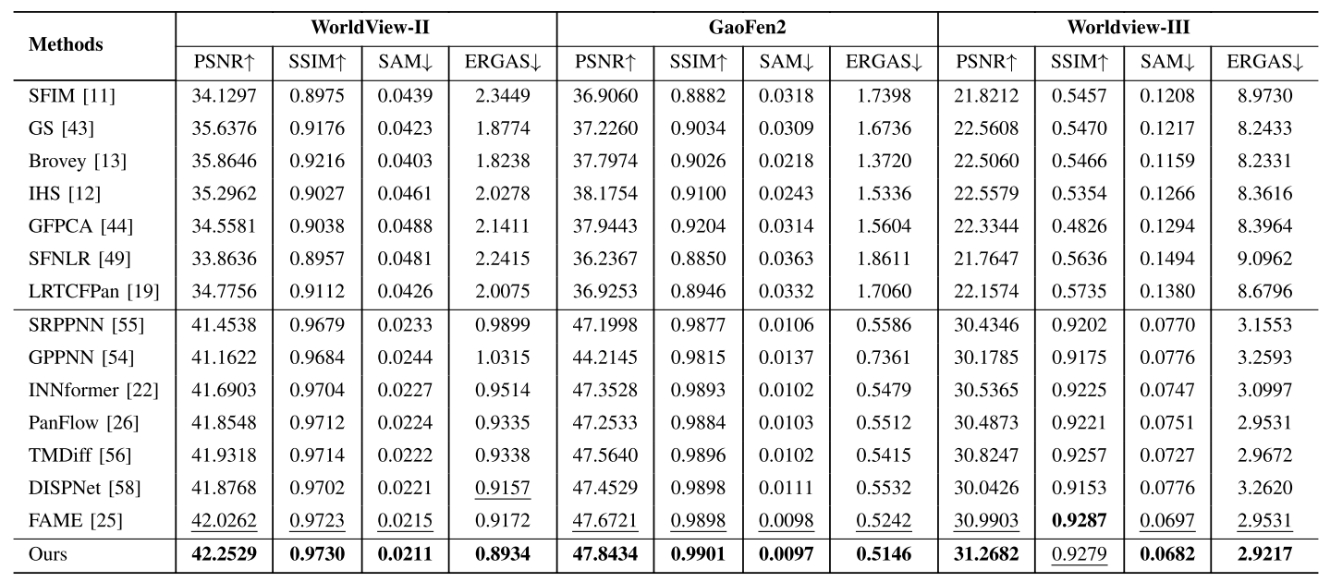

為解決上述挑戰(zhàn),研究團(tuán)隊提出了一種創(chuàng)新的文本引導(dǎo)多模態(tài)融合框架(TMMFNet)。該框架首先基于多模態(tài)大語言模型(MLLMs),結(jié)合超分辨率模型、地理空間分割模型以及思維鏈(CoT)提示技術(shù),為LRMS圖像生成高質(zhì)量的語義描述文本,從而構(gòu)建了面向全色銳化的多模態(tài)遙感數(shù)據(jù)集。此基礎(chǔ)上,團(tuán)隊設(shè)計了文本增強(qiáng)模塊(TEB)與文本調(diào)制模塊(TMB)兩個核心融合單元,能夠?qū)⑽谋局兴N(yùn)含的高層語義信息有效注入融合網(wǎng)絡(luò),從而引導(dǎo)并優(yōu)化視覺特征的融合過程。在WorldView-II、GaoFen2和WorldView-III等多個公開衛(wèi)星數(shù)據(jù)集上的實驗結(jié)果表明,所提方法在峰值信噪比(PSNR)和結(jié)構(gòu)相似性(SSIM)等關(guān)鍵評價指標(biāo)上均表現(xiàn)出優(yōu)越性能。

碩士生李薛恒為論文第一作者,謝成軍研究員、張潔副研究員為論文通訊作者。該項工作得到了安徽省自然科學(xué)基金,合肥市自然科學(xué)基金項目的支持。

論文鏈接:https://ieeexplore.ieee.org/abstract/document/11145881

圖 1 基于視覺-文本多模態(tài)融合的遙感圖像全色銳化網(wǎng)絡(luò)

圖 2 多光譜影像語義描述生成方法

表1 模型在不同數(shù)據(jù)集下的實驗結(jié)果

圖 3 不同全色銳化模型在WorldView-II數(shù)據(jù)集上的實驗結(jié)果比較